Bộ phim “người lớn” bắt đầu với cảnh một cô gái mặc áo hồng hở vai, ngồi trên giường và nở nụ cười. Mọi thứ đều giống như một kịch bản quen thuộc, chỉ trừ một điểm: gương mặt kia không phải là của diễn viên. Nó thực chất thuộc về một người phụ nữ hơn 40 tuổi, chưa từng biết đến sự tồn tại của những khung hình này cho tới khi nó bị phát tán trên mạng.

Ngay khi bắt gặp video này, cô cảm thấy hoảng loạn và chóng mặt. Cô sẽ phải đối mặt với người thân, bạn bè, đồng nghiệp như thế nào nếu họ thấy chúng? Liệu họ có tin nếu cô giải thích đây chỉ là một video giả mạo?

“Đấy là một cảm giác rất lạ. Bạn cảm thấy như bạn muốn xé bỏ tất cả mọi thứ khỏi Internet, nhưng bạn biết rõ điều đó là không thể”, người phụ nữ giấu tên chia sẻ với Washington Post.

Người phụ nữ nói trên là một nạn nhân của deepfake, công nghệ ghép khuôn mặt vào video bằng cách ứng dụng trí tuệ nhân tạo. Deepfake chính là ví dụ rõ ràng nhất cho thấy một công cụ mạnh mẽ như AI có thể gây hậu quả lớn như thế nào khi được dùng sai cách.

Video giả mạo cựu Tổng thống Mỹ Obama Năm 2017, dùng kỹ thuật tinh vi, tác giả của đoạn video khiến cả thế giới kinh ngạc vì độ chân thật của video. Khái niệm deepfake bắt nguồn từ thời điểm này.

Ghép mặt như thật

Những bức ảnh và video ghép mặt đã có từ rất lâu. Trước khi trào lưu deepfake xuất hiện, công nghệ trí tuệ nhân tạo cũng từng được ứng dụng để ghép mặt những nhân vật nổi tiếng.

Vào tháng 7/2017, nhóm nghiên cứu tại đại học Washington trở nên nổi tiếng khi công bố clip ghép mặt của Cựu Tổng thống Mỹ Barack Obama với giọng đọc của một người khác.

Tuy nhiên deepfake chỉ trở thành một danh từ vào tháng 12/2017, khi người dùng có tên “deepfakes” trên Reddit công bố một loạt video khiêu dâm trên diễn đàn Reddit. Người dùng này đã sử dụng trí tuệ nhân tạo để ghép mặt các diễn viên nổi tiếng như Scarlett Johansson hay Gal Gadot vào cơ thể của những diễn viên khiêu dâm.

Những video với khuôn mặt ghép rất giống này lập tức gây nên làn sóng phản đối. Vào năm 2018, Reddit đã đóng một loạt mục chia sẻ những video deepfake. Sau đó Twitter cũng vào cuộc khi chặn các bài viết chia sẻ. Một trang web chuyên chia sẻ phim người lớn cũng cấm cửa những video dạng này.

Dù vậy, deepfake đã kịp để lại sự lo lắng và hoang mang cho nhiều người. Những bước để tạo nên một video ghép mặt giả mạo không hề đơn giản, nhưng cách làm và công cụ thì có sẵn trên mạng. Người dùng deepfakes cho biết anh ta chỉ cần sử dụng những clip từ YouTube, ảnh tìm kiếm từ Google và một vài thuật toán mã nguồn mở như Google TensorFlow để cho cỗ máy “học”.

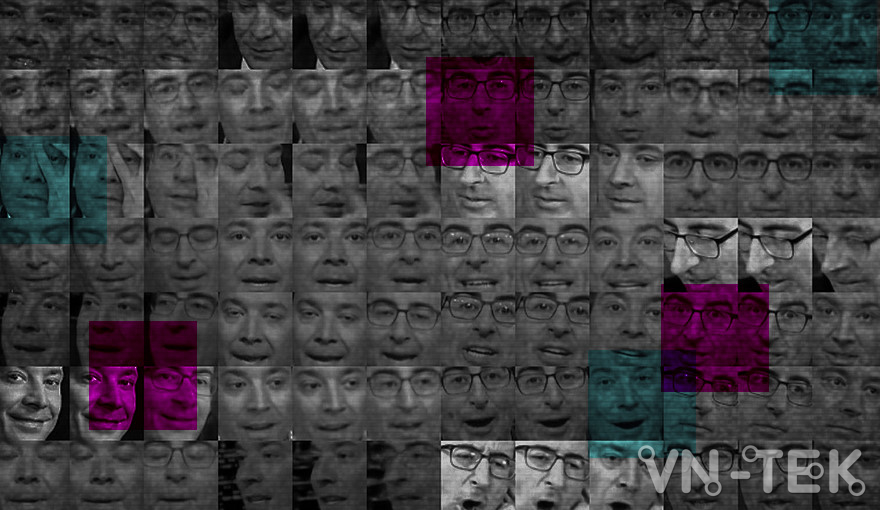

Quá trình “học” chính là đóng góp mấu chốt của trí tuệ nhân tạo. Mọi sản phẩm sử dụng trí tuệ nhân tạo đều trải qua hai bước chính: nạp dữ liệu đầu vào, sau đó dựng lên mô hình và lựa chọn một thuật toán để liên tục xử lý, học từ các mô hình đó.

Trong trường hợp của deepfake, dữ liệu đầu vào là những video khiêu dâm có sẵn và hình ảnh của diễn viên có trên mạng, thuật toán mã nguồn mở của TensorFlow hoặc Keras. Sau một thời gian “học”, cỗ máy đã có thể thực hiện một tác vụ, cụ thể ở đây là ghép khuôn mặt với độ giống cao.

Dữ liệu và thuật toán đã có sẵn trên mạng, và đáng lo ngại hơn là quá trình học, xử lý cũng không cần tới những siêu máy tính. Nhà nghiên cứu về AI Alex Champandard cho rằng một chiếc máy tính với card đồ họa phổ thông có thể thực hiện quá trình trên chỉ trong vài giờ đồng hồ. Nếu không có card đồ họa, thì vi xử lý trung tâm (CPU) cũng có thể thực hiện tác vụ, chỉ là thời gian lâu hơn, lên tới vài ngày.

“Đây không còn là thứ khoa học cao siêu nữa”, Champandard nói với Motherboard.

Bản thân deepfakes cũng thừa nhận anh chỉ là một lập trình viên bình thường và có hứng thú với công nghệ máy học, chứ không phải là một chuyên gia.

“Tôi đơn giản là tìm ra một cách dễ dàng để ghép mặt. Với hàng trăm bức hình có sẵn trên mạng, tôi có thể tạo ra hàng triệu tấm ảnh làm dữ liệu để máy tự học”, deepfake kể lại.

Ai cũng có thể là nạn nhân

Scarlett Johansson đã quá quen thuộc với những vụ tấn công vào hình ảnh của cô. Nữ diễn viên 34 tuổi xuất hiện trong hàng chục video ghép mặt trên các trang phim khiêu dâm. Trước đó, cô từng bị hacker lấy trộm ảnh nhạy cảm trong điện thoại, hay nhẹ nhàng hơn là lấy khuôn mặt ghép vào một robot.

Với Johansson, tự bảo vệ mình trên mạng là một nhiệm vụ bất khả thi, và những vụ tấn công không chỉ xảy ra với người nổi tiếng.

“Tự bảo vệ mình khỏi góc tối của Internet là một điều gần như không tưởng. Giống như nhiều thứ khác, Internet là nơi mà tình dục trở thành yếu tố được quan tâm nhất. Mọi người nghĩ rằng họ được bảo vệ bằng mật khẩu của mình, và chỉ có những người nổi tiếng mới bị tấn công. Dù vậy, chẳng có sự khác biệt giữa một vụ tấn công nhắm vào tôi hay nhắm vào người đang đứng mua hàng ngay phía sau lưng tôi. Tất cả chỉ phụ thuộc là kẻ tấn công có muốn nhắm đến bạn hay không”.

Sự nổi tiếng có thể khiến cho Johansson bị nhắm đến nhiều hơn, nhưng cũng tạo cho cô một bản lĩnh để vượt qua những vụ tấn công. Những người bình thường thì không được như vậy.

Vào tháng 4/2018, Rana Ayyub, một nhà báo điều tra tại Ấn Độ, được báo tin về video khiêu dâm ghép mặt của cô vào cơ thể một phụ nữ khác. Khi cô biết được điều này, video đã được chia sẻ hàng ngàn lần trên Facebook, Twitter, WhatsApp. Ayyub, 34 tuổi đã đối mặt với rất nhiều lời dọa nạt, tấn công trên mạng, nhưng lần này thì khác.

Ngay khi nhìn thấy video, Ayyub đã cảm thấy buồn nôn. Cô khóc nhiều ngày, và phải nhập viện vì hoảng loạn. Khi tới đồn cảnh sát, cô cảm thấy bị cười nhạo khi những người cảnh sát xem lại đoạn video.

“Đoạn phim đã thực sự đánh gục tôi. Điều duy nhất tôi cảm thấy là phải chăng đây là hình ảnh mà mọi người nghĩ về tôi. Nó còn đáng sợ hơn nhiều so với một lời đe dọa đánh đập. Nó khiến cho tôi vẫn còn bị ảnh hưởng mãi về sau. Chẳng có gì có thể ngăn cản chúng xảy ra thêm một lần nữa”.

Mọi người đều có thể là nạn nhân trong những video ghép mặt.

Với đàn ông, hầu hết video là những trò đùa, như khi diễn viên Nicolas Cage được ghép vào một bài phát biểu của Tổng thống Mỹ Donald Trump. Tuy nhiên với phụ nữ, đó là những vụ tấn công.

Có nhu cầu, ắt có người cung cấp. Kẻ tấn công tìm tới dịch vụ ghép mặt trên mạng, tại những diễn đàn mà người tham gia được giữ ẩn danh. Chỉ cần bỏ ra 20 USD là kẻ tấn công đã có thể sở hữu một video ghép mặt.

Người phụ nữ được nhắc tới ở đầu bài viết là một nạn nhân như vậy. Kẻ tấn công đã lấy gần 500 bức ảnh của cô, chủ yếu từ Facebook, không quên để lại lời nhắn “sẵn sàng trả nhiều hơn nếu video tốt”. Sau 2 ngày, hắn đã nhận được thành phẩm.

Adam Dodge, giám đốc của một đơn vị chuyên giải quyết các vụ bạo hành gia đình tại California cho rằng deepfake có thể trở thành một công cụ để những kẻ bạo hành tấn công vợ của mình.

“Với khả năng tạo video khiêm dâm như thế này, ai cũng có thể trở thành nạn nhân”.

Giới hạn nào cho deepfake

Vì tính ẩn danh của những diễn đàn, các chuyên gia pháp luật cho rằng rất khó tìm kiếm được kẻ tấn công. Việc giới hạn bằng công cụ cũng không đơn giản. Dữ liệu là những bức ảnh mà người dùng công khai trên mạng. Những thuật toán mã nguồn mở được các công ty cung cấp cho những nhà nghiên cứu, sinh viên và tất cả những ai quan tâm đến công nghệ máy học.

Mặc dù diễn đàn Reddit đã cấm những video deepfake, các công cụ tạo ra chúng lại đang được phổ biến rộng rãi. FakeApp, một công cụ chạy trên máy tính được chia sẻ trên Reddit có giao diện dễ dùng và cách sử dụng cũng rất đơn giản, chỉ cần 3 câu lệnh cơ bản. Trong bài viết hướng dẫn, người tạo ra công cụ này nhắn gửi “nếu bạn sử dụng nó, hãy dùng một cách có trách nhiệm”.

“Việc tạo ra chúng sẽ ngày càng dễ dàng hơn. Thậm chí không cần tới một video ghép mặt quá chuẩn cũng có thể dẫn đến hậu quả”, Will Knight, Biên tập viên của MIT Technology Review nói với CNBC.

Google, công ty sở hữu TensorFlow cho rằng hạn chế công cụ này sẽ khiến chính những nhà phát triển bị thiệt hại. Dù vậy ông Hany Farid, giáo sư ngành khoa học máy tính tại Đại học Dartmouth cho rằng Google cùng những tập đoàn công nghệ khác “cần nghiêm túc hơn và nhận thức được sự nguy hiểm của công nghệ này khi nó được sử dụng như một vũ khí”.

Tháng 8/2018, các nhà nghiên cứu tại Trung tâm nghiên cứu thuộc Bộ Quốc phòng Mỹ (DARPA) đã giới thiệu 1 công cụ cho phép nhận diện các video deepfake. Công cụ này còn có thể phân tích được những chi tiết mà mắt người không thể nhận ra, như phân tích phổ hoặc ánh sáng của bức ảnh để nhận ra vị trí khác biệt. Tuy nhiên, các nhà khoa học phát mình ra công cụ này thừa nhận họ vẫn phải liên tục phát triển để chạy đua với những kỹ thuật làm giả mới nhất.

Trong khi đó, những nạn nhân của deepfake rất khó chống trả. Người phụ nữ ở đầu bài viết cho biết mình đã tìm cách bảo vệ bằng luật pháp, nhưng nỗ lực không đi tới đâu. Không ai biết chân tướng kẻ tấn công là ai và đoạn video đã được phát tán rộng rãi.

VN-Tek

![[Google Drive] Win 7 64bit ghost full Soft và Driver 2017](https://vn-tek.com/wp-content/uploads/2017/11/ghost-win-7-da-cau-hinh-218x150.jpg)

![[Google Drive] Win 7 64bit ghost full Soft và Driver 2017](https://vn-tek.com/wp-content/uploads/2017/11/ghost-win-7-da-cau-hinh-100x70.jpg)